ErgoLAB Emotion面部表情分析模块,是一款专业的面部表情分析与状态识别工具。系统结合机器学习算法与图像识别技术,利用面部肌肉特征点计算和分类表情状态,自动编码多种基本表情、精确计算情感效价,系统可实时检测被试的头部位置、面部特征点、视线朝向、基本生物信息等,结合AI状态识别进一步实现对操作人员的分心、疲劳、应激等状态的自动识别以及特定环境条件下的预警反馈。

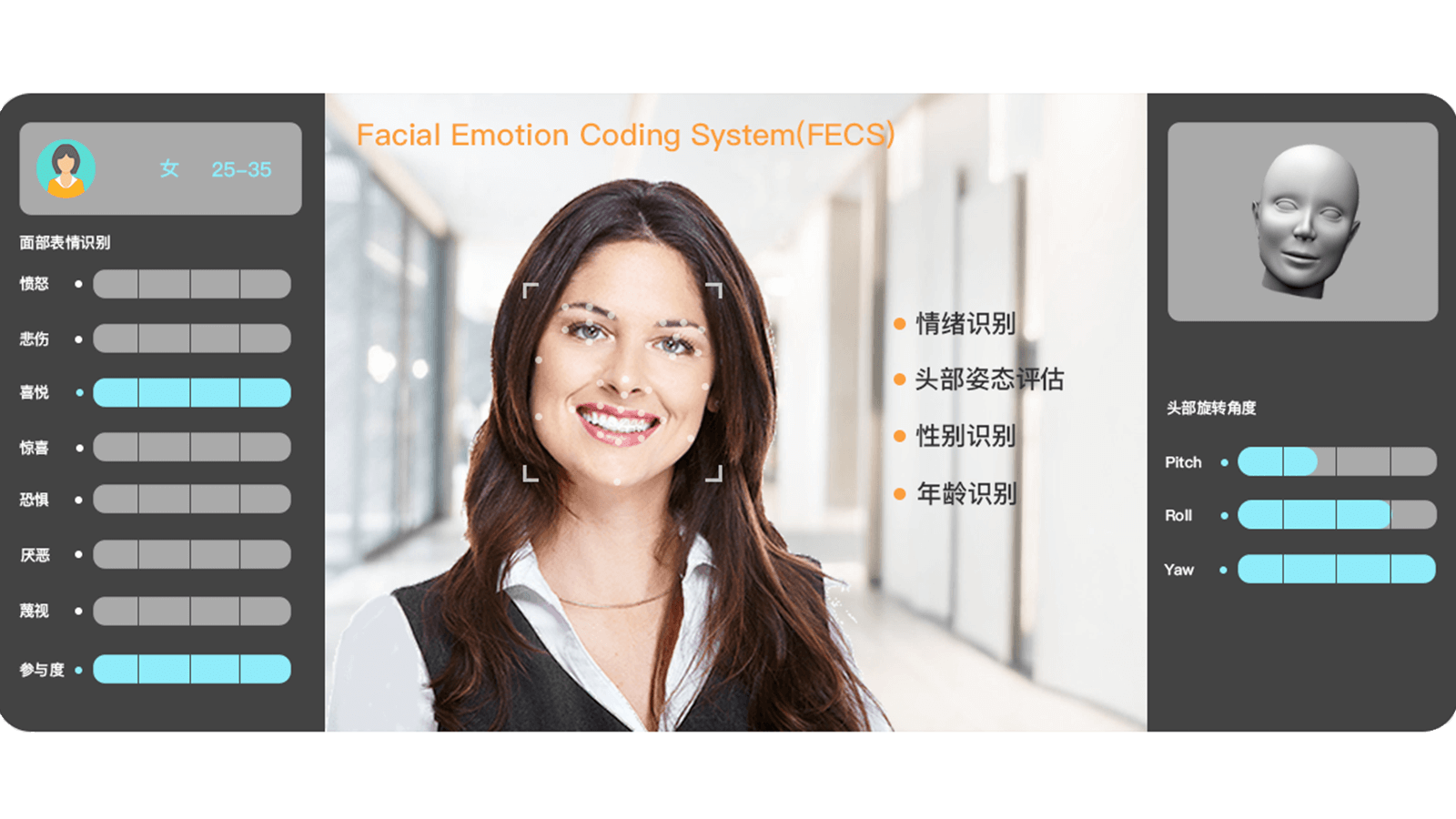

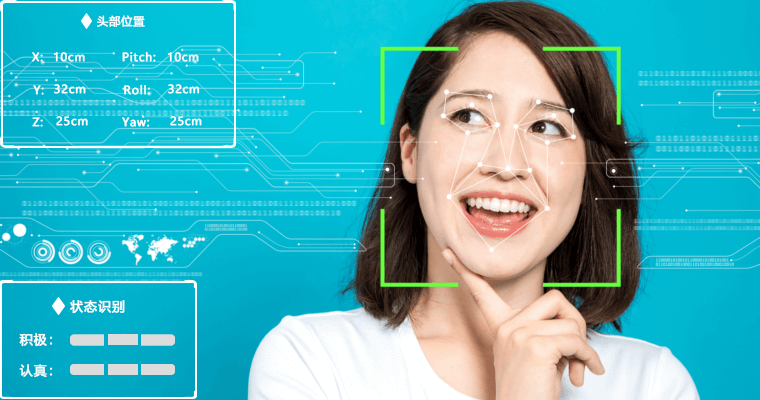

实时自动编码7种面部表情状态,包括高兴、悲伤、厌恶、恐惧、惊讶、生气、参与度。实时监测头部位置坐标Head Position,包括翻滚角Roll、偏航角Yaw、俯仰角Pitch。实时计算面部表情程度值,每种以0至100%区间计算,以及整体面部肌肉的参与度状态。精确识别个体情感效价,包括正性、中性、负性3种情感状态及21种微表情数据。自动计算个体的瞳孔距离,识别眼睛注视方向,监测注意状态。实时计算并识别多个年龄段状态,以及个体属性信息,如性别、是否佩戴眼镜。面部表情自动编码

面部表情自定义处理参数模块,包括实时处理及离线处理,如数据插值、中值滤波、均值滤波等,支持自定义程度阈值、合并阈值、以及大脑加工时间。自动识别并编码七种基本表情,包括高兴、悲伤、厌恶、恐惧、惊讶、生气、参与度,以0至100%区间计算表情程度值。计算多种微表情数据,如抬起眉毛内角、抬起眉毛外角、皱眉(降低眉毛)、上眼睑上升、脸颊提升、眼轮匝肌外圈收紧/内圈收紧、皱鼻、拉动上嘴唇向上运动、拉动人中部位的皮肤向上、拉动嘴角倾斜向上、急剧的嘴唇拉动、收紧嘴角、拉动嘴角向下倾斜、拉动下唇向下、推动下唇向上、撅嘴、嘴角拉伸、收紧双唇向外翻、眼睛扩大、张嘴等。状态识别与预警反馈

系统内嵌情感效价计算模型,精确识别积极、中性、消极情感,客观评价个体情绪状态,与多模态数据形成客观有效的印证关系;系统能够自动检测实时跟踪操作人员头部朝向,包括俯仰角、偏航角、翻滚角,并测定注视方向,计算瞳孔间距以及注意状态检测;结合人工智能与机器学习算法,进一步实现对操作人员的分心、疲劳、应激等状态的自动识别以及特定环境条件下的预警反馈。面部表情分析与统计

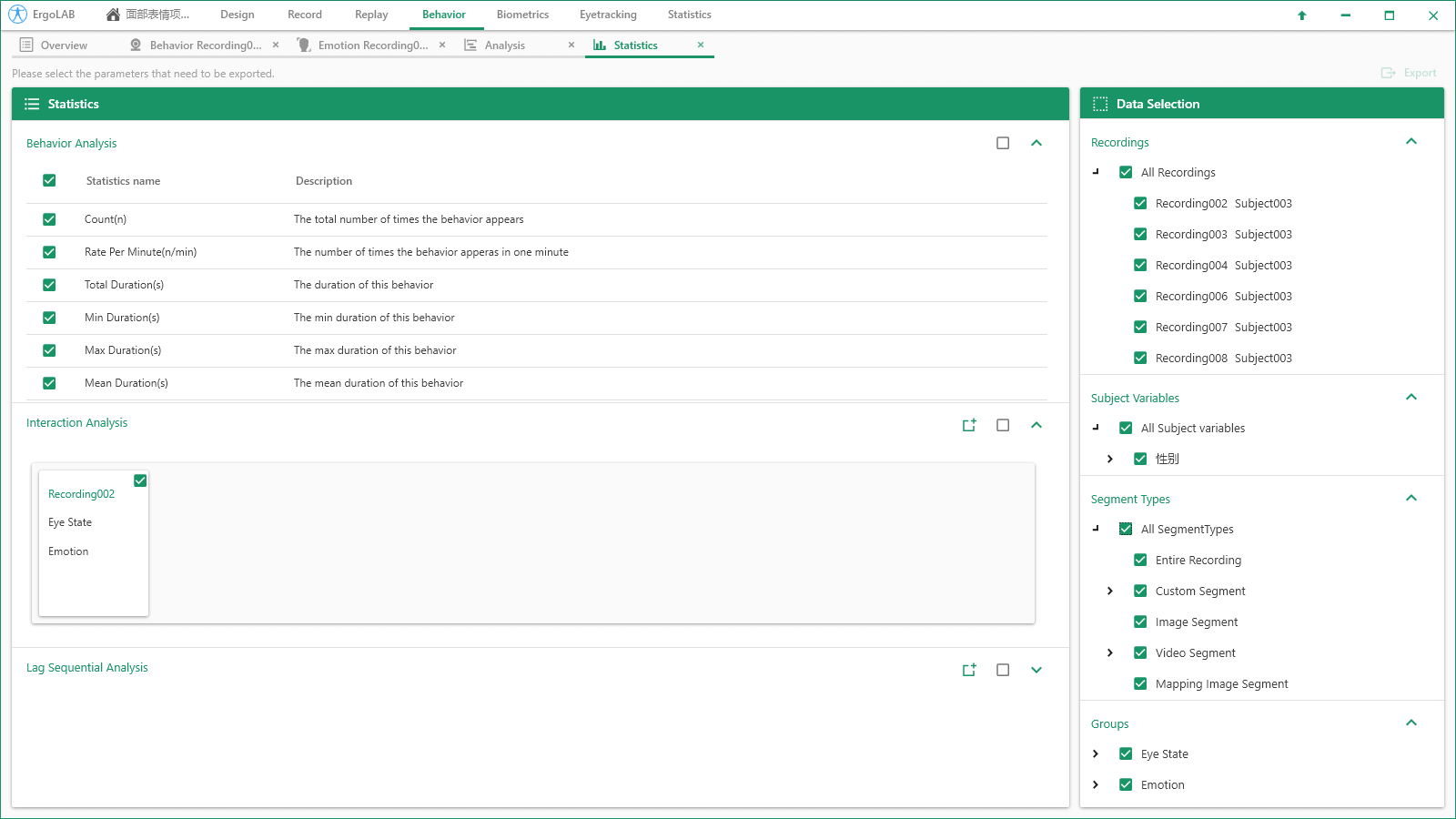

实时可视化的表情编码:系统实时计算操作人员的表情状态与情绪效价,在实验过程中,主试可实时查看与监测操作人员的表情程度与情绪变化,并做出相应的任务调整与行为预警。自动统计面部表情数据:包括每种面部表情的开始时间、结束时间、第一次发生的时间、总发生次数、频率、每次发生的时间、总的持续时间、总的持续时间在全部观察时间中所占的百分比、最短的持续时间、最长的持续时间、平均持续时间、持续时间的标准差、持续时间间隔置信区间等数据。多维度数据统计与二次开发

多维度数据交叉统计:系统支持面部表情数据与其他多模态数据(眼动、脑电、生理、动补、行为等)的同步交叉分析,多个数据源在同一平台界面呈现,在采集的同时间轴数据里选择相应的时间片段,可同步观察和统计分析所有数据流之间的相关关系。具有API开发接口:面部表情原始数据与状态分析结果可以被其他程序实时访问,可使其它程序对被试者的情绪进行反馈。ErgoLAB人机环境同步云平台可人-机-环境多维度数据的同步采集与综合分析,包括眼动追踪、生理测量、生物力学、脑电、脑成像、行为、人机交互、动作姿态、面部表情、主观评 价、时空行为、模拟器、物理环境等,为科学研究及应用提供完整的数据指标。平台可完成完整的实验和测评流程,包括项目管理-试验设计-同步采集-信号处理-数据分析-人工智能应用-可视化报告,支持基于云架构技术的团体测试和大数据云管理。